Развитие ИИ происходит со скоростью света. С помощью новейшей технологии у пользователей появляется много прекрасных возможностей. Но наряду с полезными опциями искусственный интеллект помогает создать усовершенствованные схемы обмана.

С помощью него злоумышленники способны за несколько минут украсть деньги со счетов, добыть персональную информацию и принести убытки крупнейшим компаниям. Чтобы не попасть на удочку злоумышленников и их ИИ-помощников, стоит изучить самые популярные схемы мошенничества.

Цифровые мошенники копируют реальных людей

Злоумышленники постоянно совершенствуют схемы обмана, добывая деньги через социальные сети, мессенджеры и видео сообщения. Собирая информацию через ИИ, аферисты создают виртуальные изображения, видео и голосовые сообщения реальных людей и отправляют сообщения от их лица списку контактов.

Современные системы помогают обманщикам взламывать чужие страницы, выкрадывая фотографии, аудио и видео контент. Собирать его из открытого доступа и того проще. Далее информацию отправляют в нейросеть, чтобы запустить анализ движений, голоса и черт лица. По результатам создается deepfake. Это образ в цифровом формате, максимально схожий с прототипом.

Аферисты создают ИИ-маски знаменитостей

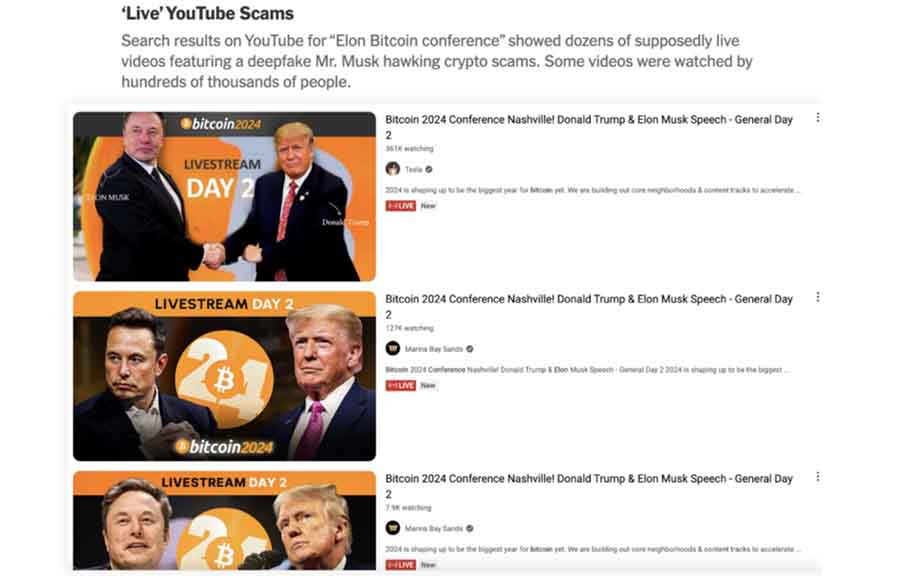

Мошенники для создания дипфейков активно используют знаменитых личностей: блогеров, владельцев крупнейших мировых холдингов, телезвезд. Самой популярной мишенью для злоумышленников оказался Илон Маск. Преимущественно его образ используется в криптовалютном и инвестиционном мошенничестве по всему миру. Вирусные ролики распространяются через самые известные социальные сети и видеохостинги.

ЧИТАЙТЕ ТАКЖЕ: Миллионы каждому узбеку — как работает лохотрон Minfin UZ Yagona kompensatsiya reestri

Чтобы привлечь внимание к лжеброкеру, обманщики применяют искусственный интеллект и создают видео, где успешный изобретатель и предприниматель рассказывает о преимуществах компании, гарантируя крупную прибыль. Чтобы создать фейк, больше не нужно много денег или времени.

Второе место по популярности у мошенников занимает Павел Дуров. С июля 2024 года в социальной сети Facebook стали появляться рекламные видео, презентующие фейковые инвестпроекты. Дополнительно обманщики запускают десятки фишинговых сайтов с криптовалютой Toncoin от его имени. Пользователи создают кошелек по инструкции, скачивая на компьютер вредоносное программное обеспечение. В результате злоумышленники могут за несколько кликов вывести средства жертв на подставные счета.

Мошенники дают поручения с deepfake руководителей

Еще несколько лет назад создание дипфейков требовало крупных денежных вложений, но с развитием ИИ она стала доступна для многих аферистов. Один из самых известных случаев произошел в 2019 году. Директор крупнейшей энергетической организации в Великобритании провел транзакцию в 243 000 аров. США после звонка мошенников, которые имитировали голос начальника. С тех пор программы, генерирующие аудио и видеофайлы, получили еще более широкое распространение.

Количество злоумышленников продолжает расти по всему миру. В Гонконге сотрудник крупнейшего холдинга по указанию «финансового директора» через видеосвязь отправил на неизвестный счет 25 млн USD. Обман удалось раскрыть спустя неделю после звонка в главный офис.

В РФ поддельные обращения от руководителей чаще велят бухгалтерам срочно перевести деньги куда скажут, спасая компанию от налоговой проверки, гибели, а шефа и главбуха от тюрьмы. Либо предупреждают, что сотрудником интересовались сотрудники полиции либо ФСБ, которые скоро свяжутся напрямую. И начальство настоятельно рекомендует выполнять их инструкции со всем тщанием. Звонки сводятся к предложению перевести деньги на указанный жуликами «безопасный счет» в обертке какой-то легенды.

Правовая помощь в возврате средств

Получите оценку ситуации и план действий

Обращения жуликов с дипфейков родных и друзей

Такие обращения в мессенджере и социальных сетях имеют стандартный формат: родственник или друг попал в беду (ДТП, драка, кредиты) и просит отправить деньги. Или срочно занять. Схема мошенничества используется давно, но была преобразована в аудио. «Бро, срочно займи 20 тыс. до понедельника, я так встрял потом расскажу» гораздо весомее, если приходит не простым текстовым сообщением, а звучит голосом реального знакомого.

Кроме выманивания денег обманщики могут дополнительно использовать фишинг. Близким человека предлагают перевести деньги через указанную специальную форму (банковские данные из которой попадают прямо в руки мошенникам) либо помочь товарищу подтвердить учетку, поручившись за него (т.е. позволив взломать еще и свою учетку, введя ее данные по присланной ссылке).

Чтобы человек как можно дольше восстанавливал доступ, его могут отвлекать спам-звонками и сообщениями.

Мошенники используют для шантажа интимные фото и видео, созданные с помощью ИИ

Одной из новинок индустрии давления и шантажа является создание порнографических роликов при помощи нейросети с жертвой в главной роли. Искусственный интеллект подставляет лицо человека и может сгенерировать копию его голоса. Мошенники начинают требовать деньги и грозят разослать ролик знакомым и родственникам.

Известный случай аферы произошел в Санкт-Петербурге. Девушке позвонили злоумышленники и потребовали деньги за сестру, которая якобы оформила много микрозаймов и просрочила оплату. После отказа героини, обманщики применили психологическое давление. Они отправили на телефон сгенерированный ролик деликатного характера якобы с ее участием и грозили опубликовать его в интернете, если она не переведет деньги. Девушка не поддалась давлению и написала заявление в полицию.

Есть сведения, что фейковые инвестиционные проекты и лжеброкеры также могут оказывать давление на жертв подобными методами. Особенно если общение с менеджерами мошенников велись в мессенджере, где хватает материала для скармливания нейросети.

Звонок от дипфейка недавно умерших

Это, пожалуй, самый циничный вариант. Люди получают звонки от умерших родственников и друзей, которые просят перевести деньги на конкретный счет. Преимущественно мошенники не уточняют на какие цели потребовались средства почившему человеку.

Чтобы сгенерировать голос умершего, используется нейросеть. Есть много случаев, когда покойные друзья и родственники просили живых вернуть долг, который не успели погасить до смерти. И который как незавершенное дело якобы не пускает их на покой.

Как еще мошенники используют нейросети

Для обеспечения постоянного притока денег, кибермошенники постоянно изобретают новые схемы обмана, а которых может помочь искусственный интеллект. К наиболее распространенным методам относятся следующие.

1 Методология социальной инженерии. Система мошенничества работает на основе манипулирования и психологического давления. Часто аферисты создают фейковую деловую переписку, пользуются вишингом и фишингом, угрожают компроматом.

Искусственный интеллект помогает генерировать мошеннические сообщения в автоматическом порядке. Поэтому с каждым днем масштаб работы аферистов продолжает увеличиваться, принося плоды.

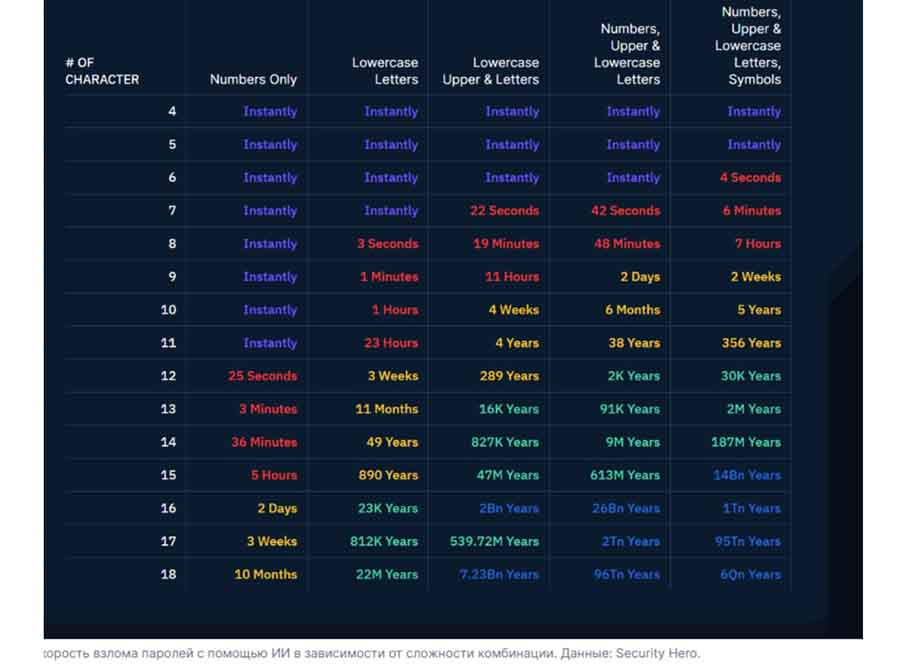

2 Взлом паролей с помощью ИИ. Компания SecurityHero провела качественное исследование продуктивности использования ИИ для взлома паролей в 2023 году. Для этого в нейросеть было отправлено 15 млн учеток.

Согласно полученным данным, 51 % паролей был взломан менее чем за 60 секунд. В течение часа цифра выросла до 65 %, за 24 часа – 71 %. За 1 месяц работы ИИ показатель успешного подбора возрос до 81 %.

3 Манипуляции посредством видео- и аудиоконтента. С октября 2024 года выявлена схема обмана, когда аферисты использовали видео и фото привлекательных женщин, чтобы мотивировать мужчин вложиться в криптовалюту. В результате злоумышленникам удалось украсть 46 млн $.

Похожая ситуация произошла в филиале крупного холдинга в Гонконге. С помощью дипфейка аферисты создали образ директора и провели убедительный видеозвонок. В итоге сотрудник финансового подразделения отправил мошенникам 25 млн долларов.

4 Подмена информации с помощью нейросетей. Эксперты Техасского университета смогли рассекретить еще одну мошенническую систему, действовавшую по образу MicrosoftCopilot. С помощью ИИ аферисты генерировали обманную информацию с активными ссылками, в том числе в уже размещенных в сети материалах. Даже после удаления адресов искажение информации в системе сохранялось. Чтобы выявить такую подмену, нужно много времени. Поэтому материальный ущерб может достигать крупных масштабов, а перед аферистами открываются огромные возможности для влияния на множество людей через Интернет через якобы приличные источники.

ЧИТАЙТЕ ТАКЖЕ: «Ваши деньги пытаются похитить, зафиксирована подозрительная операция!» Топ 8 фраз, которые используют мошенники

Как противостоять дипфейкам от мошенников

Эксперты разработали несколько рекомендаций для выявления ИИ при видеозвонках.

- попросите собеседника сесть таким образом, чтобы было видно его мимику. Если картинка нечеткая или прослеживаются странные выражения лица, значит это дипфейк;

- нужно посмотреть на границы лица, так как маска преимущественно ориентирована на верхнюю часть тела;

- попросите человека сделать поворот головы. Если перед вами дипфейк, изображение начнет плыть.

Если идет аудиозвонок, то распознать афериста труднее. Здесь нужно обратить внимание на интонацию. Монотонная речь без эмоций должна вызвать сомнения и указывать на использование нейросети.

Подробнее о способах защиты финансов от покушений с помощью искусственного интеллекта читайте в этой статье.

Заключение

Работа искусственного интеллекта оказывает влияние на все сферы деятельности человека, индустрия мошенничества не является исключением. Важно понимать, какие признаки могут свидетельствовать об обмане, изучать актуальные схемы. Так пользователи сократят риски денежных и информационных потерь, избегая неприятной встречи с обманщиками.

Поделитесь статьей в своих соцсетях: это поможет вашим читателям не пополнить список мошенников, использующих ИИ как оружие.